助力深度学习 NVIDIA发布两款GPU加速器

NVIDIA 今天宣布,旗下基于 Pascal? 架构的深度学习平台再添新成员:新款 NVIDIA? Tesla? P4 和 P40 GPU 加速器及新软件带来大幅飙升的效率和速度,能更快速地处理人工智能服务的推理工作负载。

NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生向大家介绍新款Tesla P4和P40加速器

语音激活的帮助、垃圾邮件过滤器以及电影和产品推荐引擎等现代 AI 服务正迅速变得更复杂,需要的计算能力比一年前的神经网络最高高出 10 倍。目前基于 CPU 的技术无法提供现代 AI 服务所需的实时响应能力,导致用户体验较差。

Tesla P4 和 P40 专门设计为执行推理,也即使用经过训练的深度神经网络来识别语音、图像或文字,以响应用户和设备的查询。这两款 GPU 基于 Pascal 架构,包含基于 8 位 (INT8) 数据的专用推理指令,响应速度比 CPU 快 45 倍(1),并且比发布尚不满一年的 GPU 解决方案快 4 倍。

Tesla P4 为超大规模数据中心提供极高的能效。它外形小巧,能装入大多数服务器中,而且功耗极低(初始功率只有 50 瓦特),能效与处理推理工作负载的 CPU 相比提高 40 倍。对于视频推理工作负载,一台配备单个 Tesla P4 的服务器可以取代 13 台 CPU 服务器(2),而且总体拥有成本(包括服务器成本和电力成本)可节省超过 800%。

Tesla P40 提供非常高的深度学习工作负载处理能力。它包含的 INT8 指令带来 47 万亿次运算/秒 (TOPS) 的推理性能,使得一台配备八个 Tesla P40 加速器的服务器在性能上可以取代超过 140 台 CPU 服务器。(3)按每台服务器的成本大约 5,000 美元计算,仅服务器购置成本就能节省超过 65 万美元。

NVIDIA 加速计算事业部总经理 Ian Buck 说道:“凭借 Tesla P100 以及今天推出的 Tesla P4 和 P40,NVIDIA 为数据中心带来了极其罕见的端到端深度学习平台,让各行各业都能淋漓尽致地发挥 AI 的巨大潜能。它们使训练时间从几天缩短到几小时,让用户能立即洞察玄机,还能实时响应消费者的询问,向他们提供意见或建议。”

能加快推理速度的软件工具

两款创新的软件助力 Tesla P4 和 P40,显著加快 AI 推理速度,它们就是:NVIDIA TensorRT 和 NVIDIA DeepStream SDK。

TensorRT 是为优化将部署到生产环境的深度学习模型而创建的库,能即时响应极其复杂的网络。它通常以 32 位或 16 位数据的形式获取接受训练的神经网络,并针对降低了精度的 INT8 操作优化这些网络,从而最大程度地提高深度学习应用程序的处理能力和效率。

NVIDIA DeepStream SDK 利用 Pascal 服务器的强大功能同时对最多达 93 路的高清视频流进行实时解码和分析,相比之下,双 CPU 服务器只能对 7 路视频流这样做。这解决了 AI 领域的一大挑战:在自动驾驶汽车、交互式机器人、过滤和广告投放等应用场合下,理解大批量的视频内容。通过将深度学习能力集成到视频应用程序中,公司能够提供以前不可能提供的创新型智能视频服务。

让客户的服务水平实现飞跃

如今,NVIDIA 客户提供越来越新颖的 AI 服务,这些服务需要极高的计算性能。

百度高级研究人员 Greg Diamos 说道:“向每个用户提供简单和快速响应的体验对我们很重要。我们在生产环境中部署了 NVIDIA GPU,提供由 AI 驱动的服务,例如我们的 Deep Speech 2 系统。通过使用 GPU,响应速度达到了未经加速的服务器不可企及的水平。具备 INT8 功能的 Pascal 将实现更大的飞跃,我们期待它能给用户带来更好的体验。”

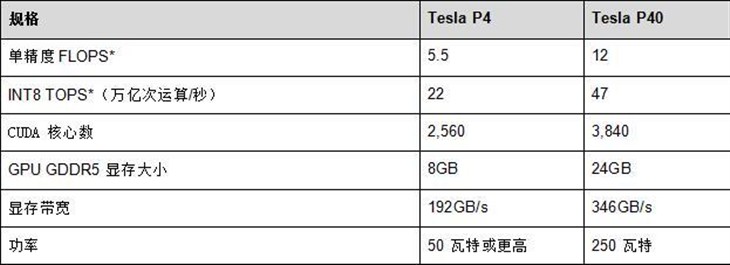

规格:

■

关注我们